Soleil du sud et chaleur humaine au rendez-vous, une opportunité inouïe de découvrir en avant-première le monde du digital et de l’audiovisuel de demain. The Media Faculty a convié nos étudiants du DMC, pour leur plus grand bonheur, les 17 et 18 octobre à Marseille, comme à l’accoutumée. Cette rencontre annuelle coordonnée par Jérôme Chouraqui, président du Média Club, a débuté par un petit déjeuner convivial. Moment sympa qui ravive les papilles et permet à nos étudiants de discuter avec des professionnels, comme Morgann Brun, cheffe de projet du studio La Planète Rouge.

Les journées sont organisées par groupe d’ateliers, répartis le matin et l’après-midi, et réunissant les participants dans plusieurs salles du cinéma l’Artplexe Canebière. Le premier jour, 3 ateliers se suivent: Rémi Tereszkiewicz (Beta Series); Marianne Carpentier et Margot Wilwertz (Newen Studio); et Jean-Yves Le Moine (Human2AI & Film2AI) Entre 2 ateliers, la bonne surprise est de croiser, notre cher coordinateur du DMC, le fameux Cyril Barthet. L’après-midi, nos étudiants ont enchainé avec 3 autres sessions: Olivier Penin (TF1); Julien Smadja (M6); Bruno Maugery (Meta) et Olivier Reynaud (Aide) ont conclu ensemble.

La journée formelle finie, la soirée informelle a lieu autour d’un cocktail dinatoire dans un hôtel avoisinant le lieu du séminaire, où tous les professionnels sont réunis. À travers une ambiance décontractée, des échanges avec les intervenants de la journée ont pu être approfondis. Nos étudiants ont eu la chance de discuter longuement avec Olivier Penin, Julien Smadja et Margot Wilwertz. Les étudiants, baignés dans cette atmosphère où rires, pâtisseries et verres s’entrelacent, ont été abreuvés de savoir sur les domaines du digital, des médias et du cinéma.

La seconde journée, comme la veille, démarre par le petit déjeuner, ainsi que 3 nouveaux ateliers: Gilles Guerraz (créateur de la newsletter « IA Générative »); Grégoire Parcollet (TransPerfect); David Defendi (Genario). Laprès-midi, débute tambour battant, par l’intervention de Laurent Sequaris du groupe Canal +, suivie de Gilles Guerra et conclue ensemble par Juliette Laniez (Google News) accompagnée de Johann Choron (Youtube).

Enfin, à l’heure du départ pour la gare Saint-Charles, nos étudiants peuvent affirmer qu’ils se sont ouverts aux opportunités de l’IA. En effet, cet outil peut être l’acteur d’un chamboulement important sur le devenir et la manière d’aborder de nombreux aspects de la télévision, du cinéma et des plateformes.

Comment trouver la bonne formule pour concilier un nouveau monde et un public en expectative face à tant de promesses d’innovations ?

IA : La boîte à outils.

Lors de notre séjour marseillais, nous avons eu l’occasion de découvrir de nouveaux outils autour de l’intelligence artificielle et d’approfondir nos connaissances sur certains.

Évidemment, l’incontournable ChatGPT était de la partie et nous en avons eu une présentation complète afin de le prendre en main et de le paramétrer à notre guise. Néanmoins, le focus de ces deux jours était bien sûr autour de l’IA générative et de son impact sur l’industrie audiovisuelle : génération de graphiques grâce à l’exploitation de données en un éclair, de contenus adaptés aux réseaux sociaux, ainsi que d’images, de vidéos, de voix et même de musiques…

Nous avons eu des ateliers sur la génération d’images nous montrant le panorama des différents outils existants aujourd’hui ainsi que leurs spécificités. Open AI (ChatGPT), génère des images avec Dall-e avec un rendu “cartoonesque” difficilement utilisable par les entreprises, Midjourney permet de paramétrer en amont quel type de rendu l’on souhaite obtenir, et Flux, par sa capacité à créer des rendus réalistes, est souvent utilisé pour les deepfakes.

Quant à Sora, Runway, Kling, Hailuo, Minimax et Luma, ces IA peuvent être utilisées pour la génération de vidéos, produites avec un prompt (text to video) ou avec une image donnée à la plateforme. Ces vidéos, qui sont pour l’instant limitées à quelques secondes, doivent néanmoins d’abord être retravaillées en postproduction et nécessite également une grande quantité de vidéos générées afin de créer une séquence intéressante. Il existe tout de même de nombreux artistes utilisant ces outils dans leur processus créatif. On peut citer par exemple le studio Shy Kids, qui a réalisé le court-métrage Airhead avec le logiciel Sora.

Les outils traditionnellement utilisés par les designers intègrent dorénavant leurs propres fonctionnalités d’IA générative, comme Adobe avec Firefly, qui permet de faire en quelques minutes une tâche qui pouvait auparavant prendre plusieurs heures. Libérant ainsi du temps aux utilisateurs, ils peuvent désormais se concentrer sur d’autres tâches ou prendre plus de temps pour peaufiner leurs projets et obtenir un meilleur rendu.

À l’heure actuelle, la question des droits d’auteurs des images générées étant floues, les entreprises s’en servent surtout comme source d’inspiration, avant de demander à des artistes de les retravailler.

Bien évidemment, la génération ne se limite pas seulement à du visuel. Des outils comme Eleven Labs ou Suno permettent de créer des musiques, des bruitages et des voix en choisissant le style, la durée et le thème.

Des entreprises de doublages se sont donc emparées du sujet afin d’en étudier les possibilités. À l’heure actuelle, faire du doublage intégralement avec de l’IA n’est pas possible, les émotions des voix n’étant pas encore convaincantes. C’est pourquoi certaines entreprises ont eu l’idée, en modifiant le timbre de voix grâce à l’IA, d’employer un seul comédien de doublage pour tourner chaque rôle (homme et femme). Les résultats sont très convaincants et permettraient de gagner du temps et faire des économies. Cela pourrait permettre à des chaînes de télévision, ayant une plateforme en ligne, d’acheter du contenu étranger avec de nombreuses saisons (k-drama ou telenovelas). Elles pourraient ensuite utiliser l’IA pour générer un doublage en français et les mettre sur leur plateforme en ligne (doublage français qui reste très important pour qu’un contenu trouve son public en France).

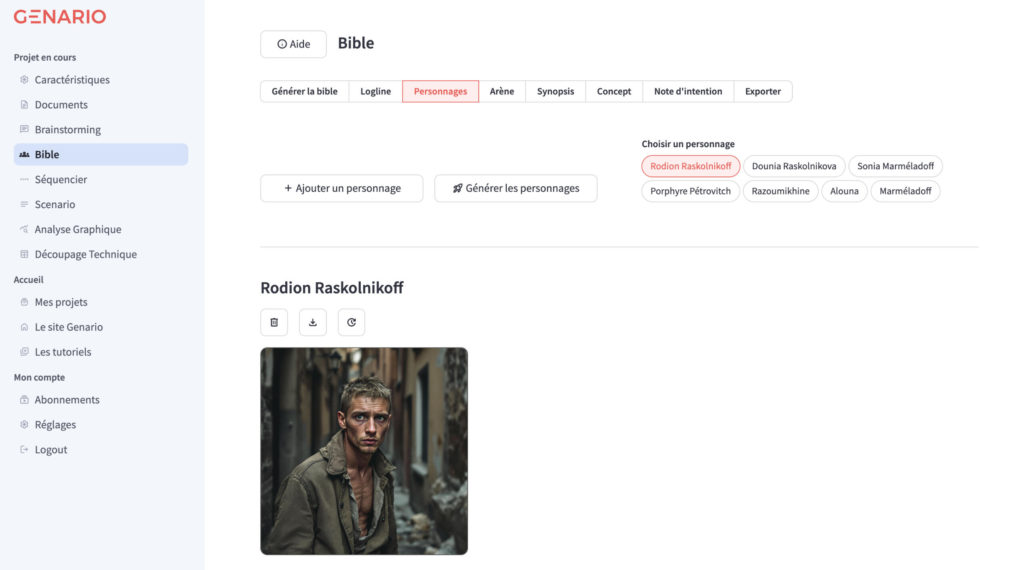

Nous avons aussi pu assister à des présentations de différents entrepreneurs travaillant dans le secteur de l’IA, comme David Defendi qui avec son logiciel Genario vise à accompagner l’industrie du cinéma et de la TV : “L’intelligence artificielle au service du scénario”. David Defendi interviendra au sein de notre master, et fera donc l’objet d’un article particulier.

L’une des entreprises qui nous ont sûrement le plus impressionné est AIVE (Artificial Intelligence for Video Experience). Grâce à AIVE, les marques ayant fait une publicité en vidéo pourraient avoir, en quelques secondes, plusieurs publications prêtes à être publiées sur différents réseaux sociaux avec différents formats. Tout cela en prenant en compte les algorithmes de chaque réseau social, pour que les publications puissent atteindre un maximum de personnes.

Nous avons également eu la chance d’avoir des présentations par les équipes de Google et de Meta, sur leurs différentes activités autour de l’IA. Durant ces 2 jours, nous avons beaucoup entendu parler de Meta et étonnamment peu de Google en dehors de leur conférence. Pourtant, l’IA de Google, Gemini, est sûrement l’une des IA les plus avancées à ce jour.

Nous ressentons en effet que Meta est en retard sur son IA générative, ce qui s’explique par le temps et l’argent investis sur le Metaverse et la réalité augmentés. Actuellement, l’entreprise propose de la génération d’image assez basique et n’a pas encore sorti d’outils pour la génération de vidéos.

Concernant l’IA Gemini de Google, ses fonctionnalités sont nombreuses et impressionnantes. Vous pouvez l’utiliser pour générer des images, ou accéder à des informations qui sont sur votre Gmail ou Google Drive. Grâce à Google Maps et Google Flight, Gemini peut également préparer vos voyages et trajets de façon efficace. Les utilisations sont nombreuses et quasi infinies, mais celle qui nous a le plus subjuguée est la possibilité de résumer une vidéo de 2h par texte ou même d’en faire un podcast entièrement généré par IA.

Les applications de l’IA au sein des groupes audiovisuels.

De Chat-GPT pour la création de prompts textuels, Ideogram pour le grapisme et design de logo, aux différents outils de génération d’images comme Dall-E, Midjourney, et même Flux, les outils d’IA générative font leur entrée dans la pré-production. Ils vont même chercher plus loin, lorgnant sur la post-production avec les techniques de cloning, clipping, et recadrages.

Ces nouvelles techniques sont convoitées ; c’est ce que les étudiants du DMC ont vu lors des deux jours de formation. Un atelier et trois conférences étaient présentés par les plus gros groupes audiovisuels français : TF1, M6, et Canal+.

La génération d’images au service de la production de contenu chez Newen Studios

Lors de l’atelier “Maîtriser la génération d’images”, Marianne Carpentier Directrice de l’innovation & des technologies et Margot Wilwertz, Cheffe de projet métavers et IA, de Newen Studios, filiale de production du groupe TF1, ont fait une présentation de l’usage des outils de génération d’images pour les stades de pré-production de projets. Elles ont expliqué que l’IA générative trouvait déjà une place dans la création de moodboards (dossiers imagés cherchant à exprimer les ambitions visuelles d’un projet, notamment de séries) mais aussi dans la création de logos pour un projet de série.

Carpentier et Wilwertz ont clarifié que l’usage de ces outils au sein de leur entreprise reste très axé sur le développement et la pré-production en interne, aux stades embryonnaires qui précèdent le besoin d’engager des professionnels. Mais que lorsqu’un logo satisfaisant est généré, il passe entre les mains d’un graphiste, qui pourra se l’approprier et faire les modifications artistiques nécessaires.

Chez TF1, l’IA est une solution applicable à plusieurs niveaux.

Parmi les conférences du premier jour, deux concernaient les usages imaginés et applications à venir des grandes chaînes de télévision hertzienne. La première de ces conférences était présentée par Olivier Penin, directeur de l’innovation de la chaîne TF1. Cette conférence se concentrait sur la manière dont TF1 compte appliquer les outils d’IA générative à ses services, notamment sur la plateforme TF1+ et la production et post-production de contenu publicitaire.

Pour Olivier Penin, les logiciels d’IA générative présentent une solution pour deux aspects majeurs du contenu que la chaîne propose sur sa plateforme de SVOD TF1+. Ces logiciels peuvent être utilisés pour enrichir l’expérience de son audience et proposer une plateforme et des chaînes plus efficaces et accessibles. TF1+ proposera bientôt un service algorithmique de recommandation nommé Synchro. Parallèlement, la plateforme offrira bientôt un service de personnalisation du contenu consistant à proposer un résumé personnalisé des actualités et contenus, inspiré d’un service déjà existant sur la plateforme Peacock, antenne du Network NBC Universal. Penin compte sur l’IA pour faciliter et accélérer l’accessibilité sur les chaînes du groupe TF1. Selon lui, les différents outils peuvent être utilisés pour générer des sous-titres et du doublage dans diverses langues, mais aussi des tags et descriptifs pour mieux indexer et archiver les programmes et pour masquer les marques apparaissant sur certains plans.

Les autres grands usages de l’IA vus par Olivier Penin concernent la production de contenus. L’IA pourra bientôt servir à la création de publicités, comme l’a prouvé une première tentative effectuée par la marque Volvo. Les différents outils ouvrent aussi des perspectives sur le traitement même de certaines productions, comme modifier le contenu après qu’il a passé le stade de la postproduction.

Pour M6, l’IA est un outil de marketing à intégrer dans le business model de l’entreprise.

À Marseille, les étudiants du DMC ont pu assister à la conférence de Julien Smadja, directeur général adjoint de M6 distribution digital chargé du streaming. Smadja a commencé sa conférence par un rapide état des lieux du potentiel actuel de l’IA, rappelant qu’aujourd’hui ces outils ne peuvent pas encore s’intégrer pleinement aux échelles de la production et de la programmation. En profitant de cet état des lieux, Julien Smadja approche les applications pratiques des outils. Selon lui, le point fort des outils de génération automatisée est l’accélération du temps de traitement et de la mise en ligne. Ainsi, l’IA trouve sa place dans les productions destinées directement aux collaborations et communications entre les entreprises et les groupes.

Pour illustrer son point de vue, Smadja a présenté deux outils considérés par la plateforme M6+ pour communiquer et mettre en avant ses partenaires. En premier lieu : l’outil Cé6lia, un LLM (Large Language Model, soit un outil de génération de texte), utilisé pour traiter des milliers de métadonnées rapidement et pouvoir ainsi faciliter les rapports de la plateforme avec ses partenaires économiques. Les outils d’IA permettent aussi d’offrir de nouveaux services aux spectateurs. Julien Smadja a présenté l’outil développé par TheTakeIA, qui permettrait de rediriger le spectateur vers une boutique en ligne dès lors qu’un produit apparaîtrait à l’écran. Ce renvoi de trafic vers des commerces pourrait représenter un nouveau modèle proche du téléachat, modèle qui a toujours fait partie de la stratégie de M6.

Un enjeu semble partagé entre M6 et TF1 : être capable de développer ses propres modèles d’IA pour garder privées les données de ces groupes.

De l’ajustement des publicités à la création prédictive : l’Intelligence Artificielle au sein du groupe Canal +

La conférence du deuxième jour, présentée par Laurent Sequaris, directeur de la création du studio de Canal+ BrandSolutions, se concentrait sur la modification des contenus publicitaires. Le but serait de les adapter aux programmes et à la création de pitchs prédictifs, rendue possible en combinant plusieurs outils. Sequaris a commencé sa présentation en expliquant que les outils d’intelligence artificielle sont utilisés au sein du groupe pour revoir les palettes couleurs des contenus publicitaires diffusées sur ses chaînes. Il a illustré son propos avec un exemple visuel d’une page publicitaire apparue sur C8 durant la diffusion du film Barbie. Les équipes de Laurent Sequaris se posent aussi la question de générer des transitions entre programmes et publicité avec les outils d’IA. Ces transitions seraient animées par l’IA et couperaient moins avec le ton d’un programme, ce qui serait ainsi bénéfique à la rétention du public.

Sequaris a aussi présenté comment le groupe Canal+ pourrait proposer un programme et anticiper ses nouvelles productions avec les outils de Machine Learning. Sequaris proposait un dispositif combinant le cloning de voix et le deepfake à la génération d’images et de vidéos, pour incruster certaines personnalités et leurs voix dans des univers fictifs distincts. Cela permettrait ainsi de pouvoir donner un premier jet, une mise en perspective du potentiel d’une idée, d’un programme ou d’un rôle. Enfin selon Sequaris, des pitchs pourraient être générés pour proposer de nouveaux programmes, films ou séries, aux équipes de production du groupe Canal+.

Abdoulaye DEMBELE, Elsa RIDOLFI, Léonard MARTI

Comments are closed